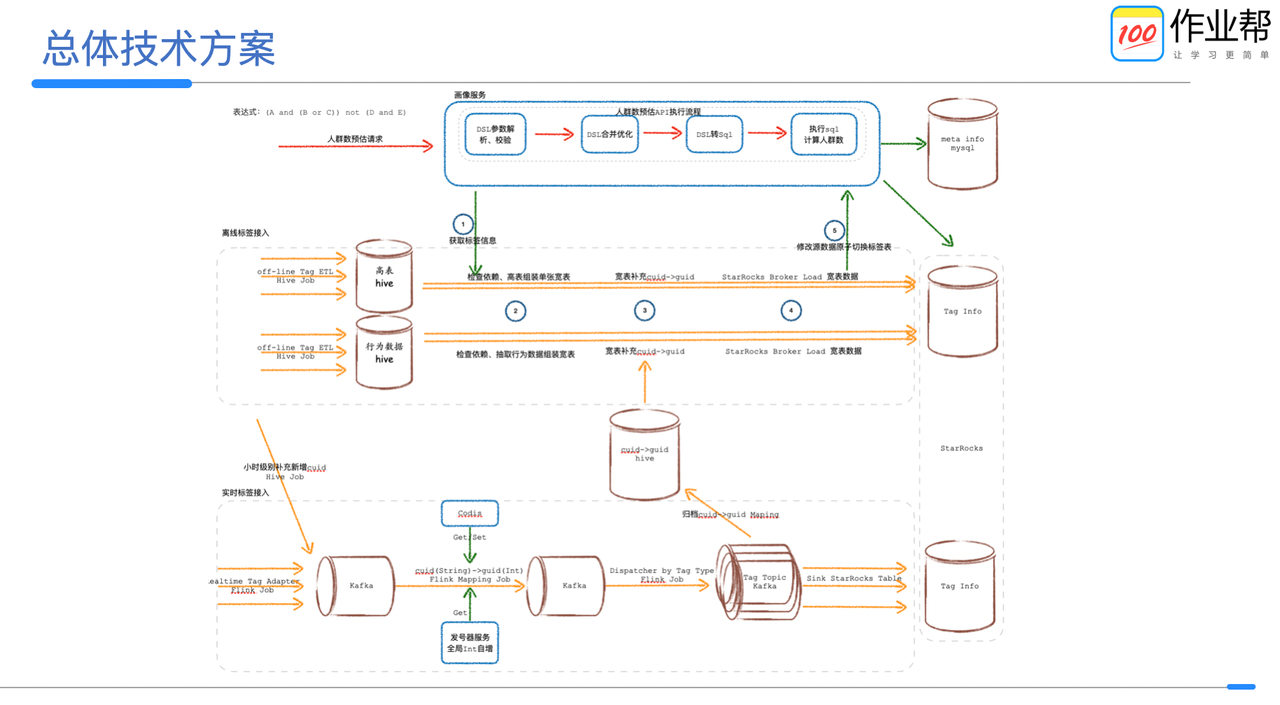

肩部肌肉

- The Anterior/Front deltoid 三角肌的前部(前束)。功能:屈曲(flexion) 、内收(adduction)、内旋(interal rotation)手臂/肩关节

- The Medial deltoid 三角肌的中部,是三角肌最大的一部分,决定肩部的宽度。功能:手臂的外展(abduction)

- The Posterior/rear deltoid 三角肌的后部(后束)/后三角肌,在肩关节的后面。功能:伸展(extension)、外展(abduction)、外旋(external rotation)手臂/肩关节

三角肌前束训练

前平举

三角肌前束的功能是屈伸内收和内旋,我们就用前平举的方法来刺激三角肌前束,这包括经典的哑铃前平举,和衍生的使用杠铃片进行前平举

- 启始:身体直立,哑铃垂在大腿前侧,手臂自然下垂。

- 脑海里浮现出肩部的样子,用肩部发力将哑铃举起,忘掉自己的手臂,上举时候身体不要晃,举至于地面平

- 在顶端停留,感受肩部的肌肉收缩,然后,还是用肩部控制放下的速度,慢慢将其放下

脊椎问题的,建议用哑铃。脊柱侧弯,会导致身体左右两侧的肌肉量和力量的不对称,如果是两手同时举起重量的动作,会导致你弱势一方发力由强的一方进行代偿,进而导致你强的一边越来越强,对于矫正没有好处

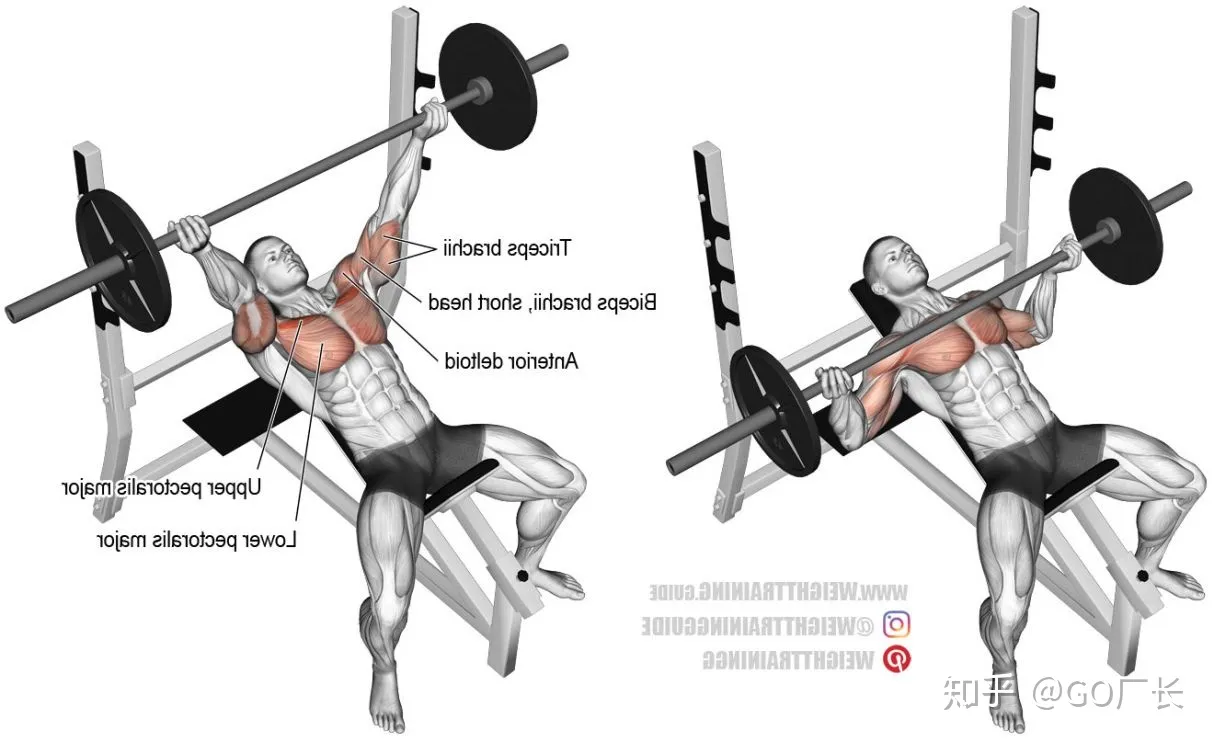

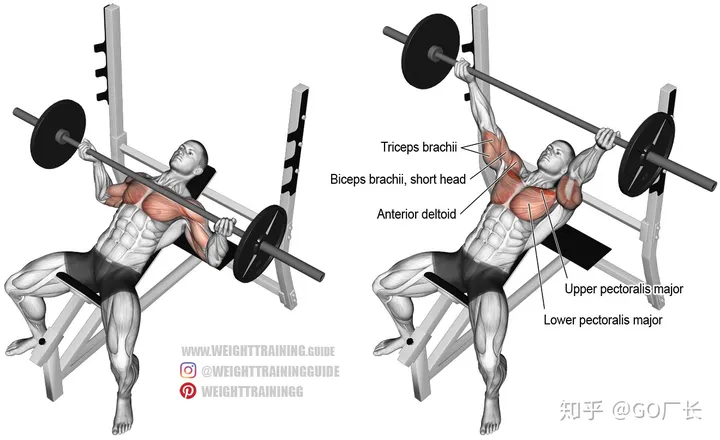

上斜卧推

杠铃上斜卧推

哑铃上斜卧推

三角肌中束训练

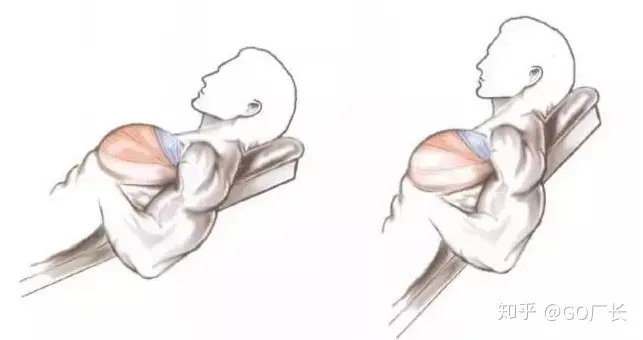

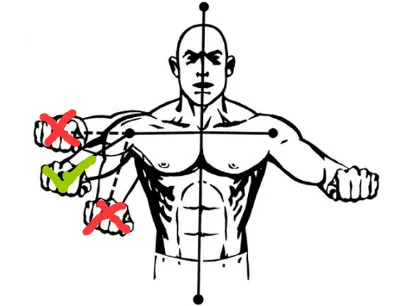

哑铃侧平举

- 不能耸肩,耸肩可能损伤颈部肌肉,

- 无需大重量

- 保持身体的稳定,别乱晃,肘部的位置不能低于手持哑铃的位置

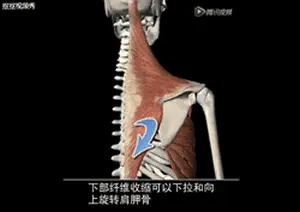

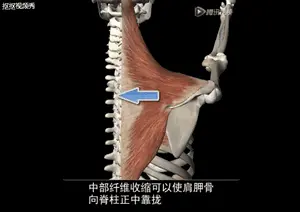

三角肌后束训练

脸拉

综合训练

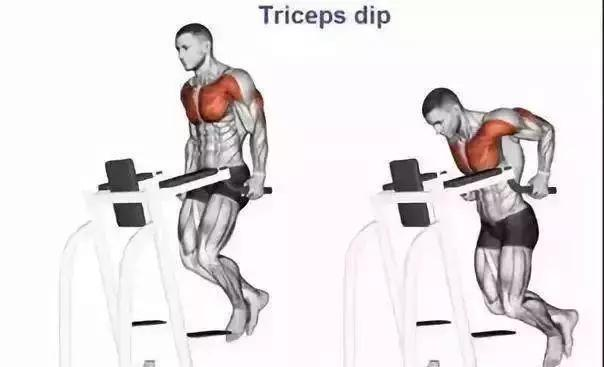

杠铃肩上举

这个动作绝非全程都是三角肌发力,复合动作,复合动作,很多肌群都在做工,在此动作的前半段,你的三角肌中束和前束占比很大,后半程三头参与很多。

举得越高,三头参与越多。

肩部训练误区

- 用的太重

肩关节是很灵过的,也是很脆弱的,因此肩膀很容易会因为大重量而受伤,提高感受度才是关键,不要一味上在肩上堆大重量 - 绝对标准的动作

每个人的肩膀结构都是不一样的,肩峰下空间大小也都不尽相同,因此要挑选适合自己的动作。在合理的条件下,一个动作要感觉不疼,不别扭 - 沉肩

刻意的沉肩有可能在侧平举的过程中造成盂肱关节上囊结构变形。如果选择沉肩,不要用大重量,会增加受伤风险。不刻意沉肩,但也不要耸肩。 - 忽略三角肌后束

这个位置自己看不到,但对于体态矫正有很大的帮助 - 局限于练肩日练肩

三角肌后束可以在练背日顺便练到,前束可以在练胸日练到 - 颈后推举

这个动作很危险,不要做